模型架构-Transformer模型

2025/6/18...大约 1 分钟

模型架构-Transformer模型

Why Attention?

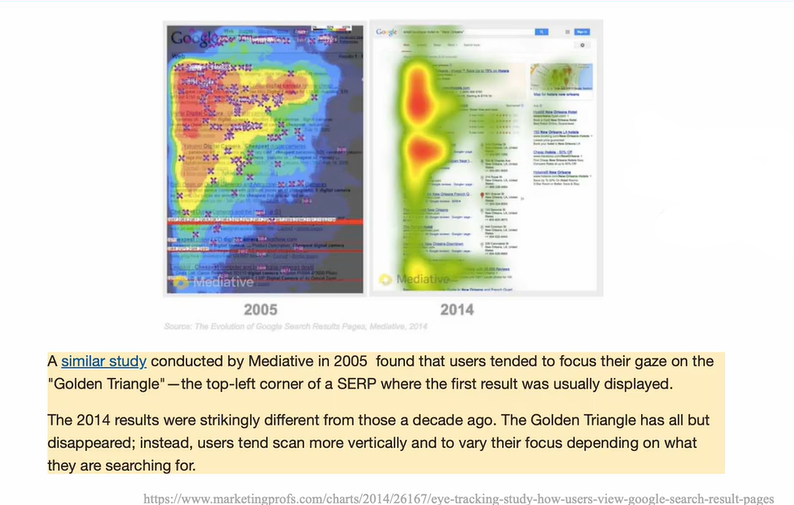

搜索场景

在搜索场景中,人们的目光往往会更加关注左上角的三角区域(即第一条搜索结果的位置)

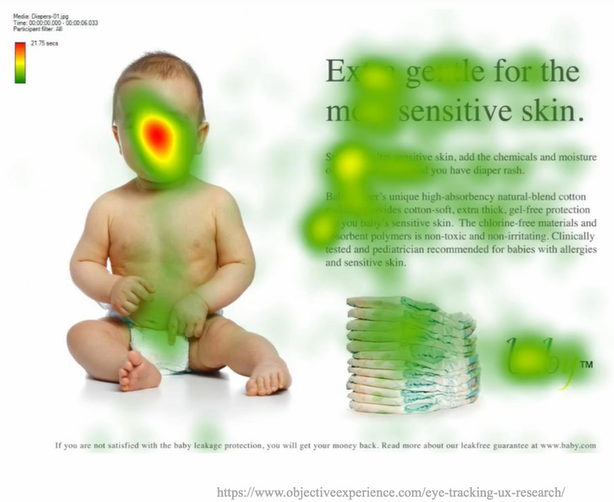

阅读中

浏览图文信息

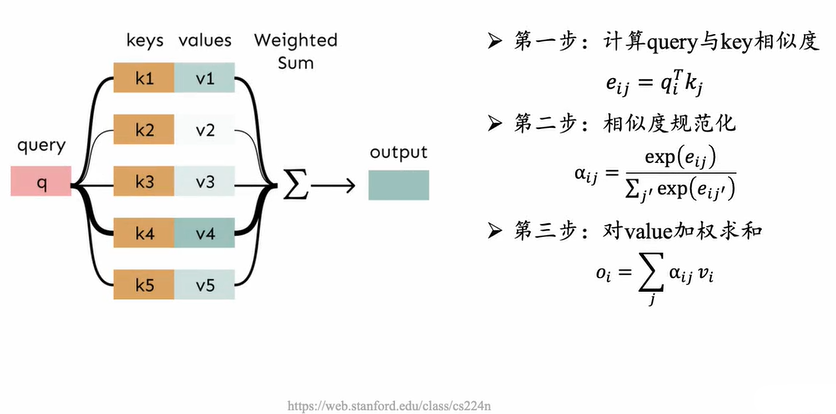

注意力机制

注意力机制,可以视为一致基于相似度的查表

核心模块: 注意力

- Transformer完全抛弃传统的CNN和RNN,整个网络结构完全由注意力机制组成

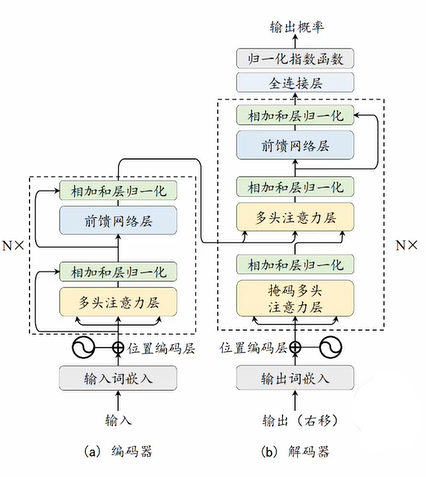

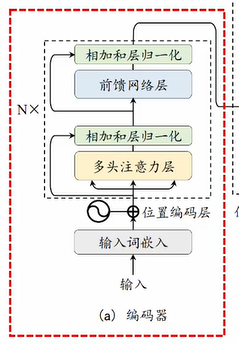

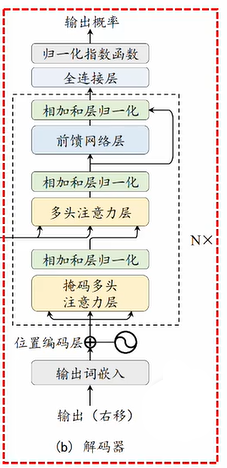

编码器-解码器结构

- 编码器将输入序列变换为隐藏层特征

- 解码器将隐藏层特征变换为输出序列

编码器:将输入变换为隐藏层特征

- N个堆叠的编码器层

- 多头注意力

- 前馈网络

- 残差连接和层归一化

解码器:将隐藏层特征变换为自然语言序列

- N个堆叠的解码器层

- (掩码)多头注意力

- 前馈网络

- 残差链接和层归一化

更新日志

2025/6/18 01:52

查看所有更新日志

ee5e6-于